Resolver los retos de la fabricación de pizzas con robots

Una nueva técnica podría permitir a un robot manipular objetos blandos como la masa de la pizza o materiales suaves como la ropa.

Imagine a un pizzero trabajando con una bola de masa. Puede utilizar una espátula para levantar la masa en una tabla de cortar y luego utilizar un rodillo para aplanarla en un círculo. Fácil, ¿verdad? No si el pizzero es un robot.

Para un robot, trabajar con un objeto deformable como la masa es complicado porque la forma de la masa puede cambiar de muchas maneras, que son difíciles de representar con una ecuación. Además, crear una nueva forma a partir de esa masa requiere múltiples pasos y el uso de diferentes herramientas. Para un robot es especialmente difícil aprender una tarea de manipulación con una larga secuencia de pasos -en la que hay muchas opciones posibles-, ya que el aprendizaje suele producirse por ensayo y error.

Investigadores del MIT, la Universidad Carnegie Mellon y la Universidad de California en San Diego han ideado una forma mejor. Han creado un marco para un sistema de manipulación robótica que utiliza un proceso de aprendizaje en dos fases, lo que podría permitir a un robot realizar complejas tareas de manipulación de la masa durante un largo periodo de tiempo. Un algoritmo "maestro" resuelve cada paso que debe dar el robot para completar la tarea. A continuación, entrena a un modelo de aprendizaje automático "alumno" que aprende ideas abstractas sobre cuándo y cómo ejecutar cada habilidad que necesita durante la tarea, como el uso de un rodillo. Con este conocimiento, el sistema razona sobre cómo ejecutar las habilidades para completar la tarea.

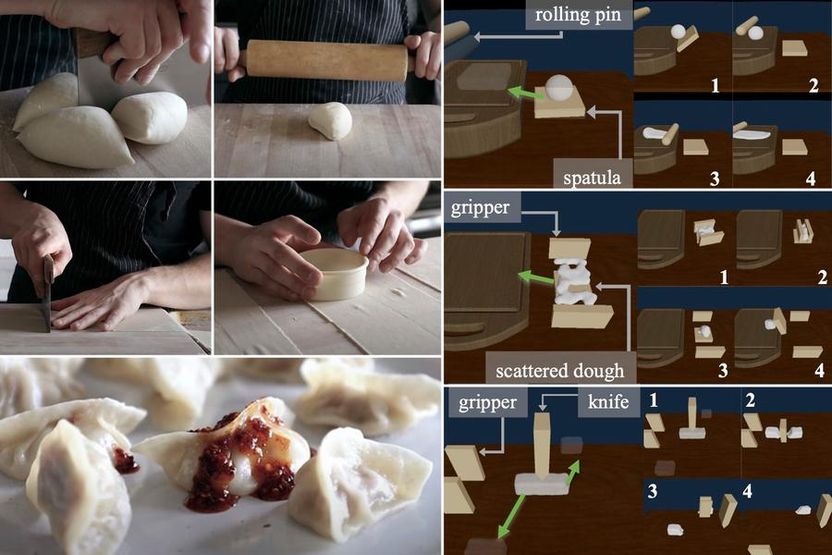

Los investigadores demuestran que este método, al que llaman DiffSkill, puede realizar tareas de manipulación complejas en simulaciones, como cortar y extender la masa, o recoger trozos de masa alrededor de una tabla de cortar, superando a otros métodos de aprendizaje automático.

Más allá de la elaboración de pizzas, este método podría aplicarse en otros entornos en los que un robot necesite manipular objetos deformables, como un robot cuidador que alimente, bañe o vista a una persona mayor o con problemas motrices.

"Este método se acerca más a la forma en que los humanos planificamos nuestras acciones. Cuando un ser humano realiza una tarea de largo alcance, no anotamos todos los detalles. Tenemos un planificador de alto nivel que nos dice a grandes rasgos cuáles son las etapas y algunos de los objetivos intermedios que tenemos que alcanzar por el camino, y luego los ejecutamos", dice Yunzhu Li, estudiante de posgrado del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL), y autor de un artículo de presentación de DiffSkill.

Entre los coautores de Li se encuentran el autor principal, Xingyu Lin, estudiante de posgrado de la Universidad Carnegie Mellon (CMU); Zhiao Huang, estudiante de posgrado de la Universidad de California en San Diego; Joshua B. Tenenbaum, profesor de desarrollo profesional Paul E. Newton, catedrático de Ciencias Cognitivas y Computación del Departamento de Ciencias Cognitivas y del Cerebro del MIT y miembro del CSAIL; David Held, profesor adjunto de la CMU; y el autor principal, Chuang Gan, investigador científico del Laboratorio de Inteligencia Artificial MIT-IBM Watson. La investigación se presentará en la Conferencia Internacional sobre el Aprendizaje de Representaciones.

Alumno y profesor

El "profesor" en el marco de DiffSkill es un algoritmo de optimización de trayectorias que puede resolver tareas de horizonte corto, en las que el estado inicial de un objeto y la ubicación del objetivo están cerca. El optimizador de trayectorias trabaja en un simulador que modela la física del mundo real (conocido como simulador de física diferenciable, lo que pone el "Diff" en "DiffSkill"). El algoritmo del "profesor" utiliza la información del simulador para aprender cómo debe moverse la masa en cada etapa, de una en una, y luego emite esas trayectorias.

A continuación, la red neuronal del "alumno" aprende a imitar las acciones del profesor. Como entradas, utiliza dos imágenes de cámara, una que muestra la masa en su estado actual y otra que muestra la masa al final de la tarea. La red neuronal genera un plan de alto nivel para determinar cómo enlazar las distintas habilidades para alcanzar el objetivo. A continuación, genera trayectorias específicas de corto horizonte para cada habilidad y envía órdenes directamente a las herramientas.

Los investigadores utilizaron esta técnica para experimentar con tres tareas diferentes de manipulación de masa simuladas. En una de ellas, el robot utiliza una espátula para levantar la masa y colocarla en una tabla de cortar, y luego utiliza un rodillo para aplanarla. En otra, el robot utiliza una pinza para recoger la masa de todo el mostrador, la coloca en una espátula y la transfiere a una tabla de cortar. En la tercera tarea, el robot corta un montón de masa por la mitad con un cuchillo y luego utiliza una pinza para transportar cada pieza a diferentes lugares.

Un corte por encima del resto

DiffSkill fue capaz de superar las técnicas más populares que se basan en el aprendizaje por refuerzo, en el que un robot aprende una tarea mediante el método de ensayo y error. De hecho, DiffSkill fue el único método capaz de completar con éxito las tres tareas de manipulación de la masa. Curiosamente, los investigadores descubrieron que la red neuronal "estudiante" era capaz incluso de superar al algoritmo "maestro", afirma Lin.

"Nuestro marco proporciona una forma novedosa de que los robots adquieran nuevas habilidades. Estas habilidades pueden encadenarse para resolver tareas más complejas que superan la capacidad de los sistemas robóticos anteriores", afirma Lin.

Como su método se centra en el control de las herramientas (espátula, cuchillo, rodillo, etc.), podría aplicarse a diferentes robots, pero sólo si utilizan las herramientas específicas que los investigadores definieron. En el futuro, planean integrar la forma de una herramienta en el razonamiento de la red "estudiante" para que pueda aplicarse a otros equipos.

Los investigadores pretenden mejorar el rendimiento de DiffSkill utilizando datos en 3D como entradas, en lugar de imágenes que pueden ser difíciles de transferir de la simulación al mundo real. También quieren hacer más eficiente el proceso de planificación de la red neuronal y recopilar datos de entrenamiento más diversos para mejorar la capacidad de DiffSkill de generalizarse a nuevas situaciones. A largo plazo, esperan aplicar DiffSkill a tareas más diversas, como la manipulación de telas.

Este trabajo ha sido financiado, en parte, por la National Science Foundation, LG Electronics, el MIT-IBM Watson AI Lab, la Office of Naval Research y el programa Machine Common Sense de la Defense Advanced Research Projects Agency.

Nota: Este artículo ha sido traducido utilizando un sistema informático sin intervención humana. LUMITOS ofrece estas traducciones automáticas para presentar una gama más amplia de noticias de actualidad. Como este artículo ha sido traducido con traducción automática, es posible que contenga errores de vocabulario, sintaxis o gramática. El artículo original en Inglés se puede encontrar aquí.